Traduction contextuelle avec de grands modèles de langage

La traduction automatique traditionnelle a posé problème pendant longtemps, même avec l'introduction de la traduction automatique neuronale et de vastes ensembles de données d'entraînement. Bien qu'elle puisse produire des résultats intéressants lorsqu'elle est finement réglée et entraînée pour un domaine spécifique avec un langage prévisible et simple, elle est généralement peu fiable et erratique lorsqu'elle est appliquée à une variété de domaines, de langues et de circonstances.

De nombreux traducteurs réputés n'aiment toujours pas la traduction automatique et refusent de l'utiliser comme premier jet ou de réécrire entièrement les flux. Cela met en évidence la division entre les machines et les humains, même avec l'immense évolution de traduction automatique au cours des dernières années. D'après notre sondage, seulement un petit pourcentage de traducteurs considèrent la traduction automatique comme un allié précieux.

La traduction automatique traditionnelle est soit trop générique et imprévisible, soit trop spécifique, nécessitant des circonstances particulières pour être efficace, telles que de grands volumes de contenu avec une structure linguistique simple ou une ségrégation de domaine comme les manuels techniques, les bases de connaissances produits et la documentation de support. Même les moteurs entraînés ont du mal à gérer les incohérences et les divergences entre les bases terminologiques, les mémoires de traduction et la formation du corpus linguistique.

Ces problèmes incluent les glossaires mis à jour par les relecteurs ou traducteurs de l'entreprise après le processus de formation, les différences entre les glossaires et le corpus de formation, la nécessité de créer et de maintenir des moteurs spécifiques pour une qualité maximale, la mémoire de traduction les écarts par rapport au corpus entraîné, et des erreurs stupides telles que la traduction d'entités ou d'autres noms propres, ainsi qu'un manque de sensibilité culturelle ou linguistique.

Ces exemples entraînent des flux peu fiables et un processus de révision difficile pour les traducteurs. De plus, la gestion des modèles de traduction automatique traduits et entraînés nécessite généralement un ou plusieurs ingénieurs en localisation dédiés à ces efforts, ce que la plupart des petites et moyennes agences de traduction et des programmes de localisation n'ont pas les ressources nécessaires pour faire.

La traduction contextuelle avec de grands modèles de langage, cependant, change la donne. Le contexte fait référence à toutes les informations qui ne sont pas le texte lui-même, mais qui aident le moteur à comprendre le texte et à le traiter. Des exemples de contexte sont les glossaires, les mémoires de traduction, les commentaires passés et le taux de rebond, mais le contexte peut être n'importe quelle information. Avec les grands modèles de langage qui peuvent prendre en compte des milliards de paramètres par conception, il n'y a vraiment aucune limite à la quantité de contexte avec laquelle vous décidez de travailler.

Voici un exemple de prise en compte du contexte:

Notez qu'il y a un flux de Mémoire de traduction de 89% et un flux de Traduction automatique. Le flux de TM appelle notre "moteur" un "moteur" en portugais tandis que le MT appelle le moteur un "mécanisme" en portugais. Cependant, le glossaire spécifie que "engine" doit être conservé comme "engine". Lorsqu'il est traité par BWX Translate, notre modèle prend en compte cette préférence (ainsi que d'autres) :

BWX Translate non seulement insère le terme correct selon la dernière version du glossaire, mais apporte également toutes les modifications nécessaires au texte afin qu'il soit bien lu dans la langue cible tout en tenant compte du contexte linguistique offert par la Translation Memory.

Avec BWX Translate, les grands modèles de langage comme ChatGPT peuvent prendre en compte leur propre ensemble de données d'entraînement, des mémoires de traduction spécifiques, des glossaires et d'autres contextes pertinents pour offrir aux traducteurs un flux de traduction nuancé, contextualisé et réfléchi dans un projet donné. Nous pouvons prendre en compte les dernières mises à jour des glossaires et des mémoires de traduction en temps réel, ce qui signifie qu'il n'est pas nécessaire de soumettre à plusieurs reprises des glossaires et des traductions mises à jour à des serveurs de traduction automatique entraînés et ajustés pour espérer qu'ils prennent en compte les préférences linguistiques.

Avec BWX Translate, vous pouvez vous entraîner et traduire à la volée, et tout projet de traduction, toute mémoire de traduction de n'importe quelle taille et tout glossaire de n'importe quelle taille peuvent bénéficier de ses capacités de fusion textuelle et de probabilité linguistique. Il n'y a pas de temps d'installation et il n'est pas nécessaire de s'entraîner au préalable.

D'après nos recherches initiales, un tel moteur peut fournir aux traducteurs des flux qui brisent la résistance de longue date à l'utilisation de la traduction automatique. Notre moteur ouvre également la porte à une conversation entre le traducteur et le moteur. Il est plus logique d'enrichir un glossaire si vous en bénéficiez instantanément, et il est plus facile de faire confiance à une machine si vous savez par expérience qu'il y a au moins quelque chose qui ressemble à une pensée critique et adaptative.

En plus de la traduction consciente du contexte, nous avons également ouvert la porte aux traducteurs pour qu'ils puissent interagir avec les modèles linguistiques afin d'obtenir un deuxième regard sur leurs choix, des suggestions alternatives, voire entamer une conversation si nécessaire.

La traduction contextuelle avec de grands modèles linguistiques est bien plus qu'un simple processus de pré-traduction amélioré. C'est un pas ferme vers la collaboration entre les humains et les machines pour produire un meilleur contenu avec moins d'efforts et en moins de temps.

À l'avenir, le contexte continuera de s'étendre de manière sans précédent et nous serons en mesure de rédiger des textes multilingues en tenant compte du comportement des utilisateurs, de l'analyse du web et d'une multitude d'autres informations qui peuvent être consommées et comprises par de grands modèles linguistiques. Ce n'est que le tout début et cela a déjà tout changé.

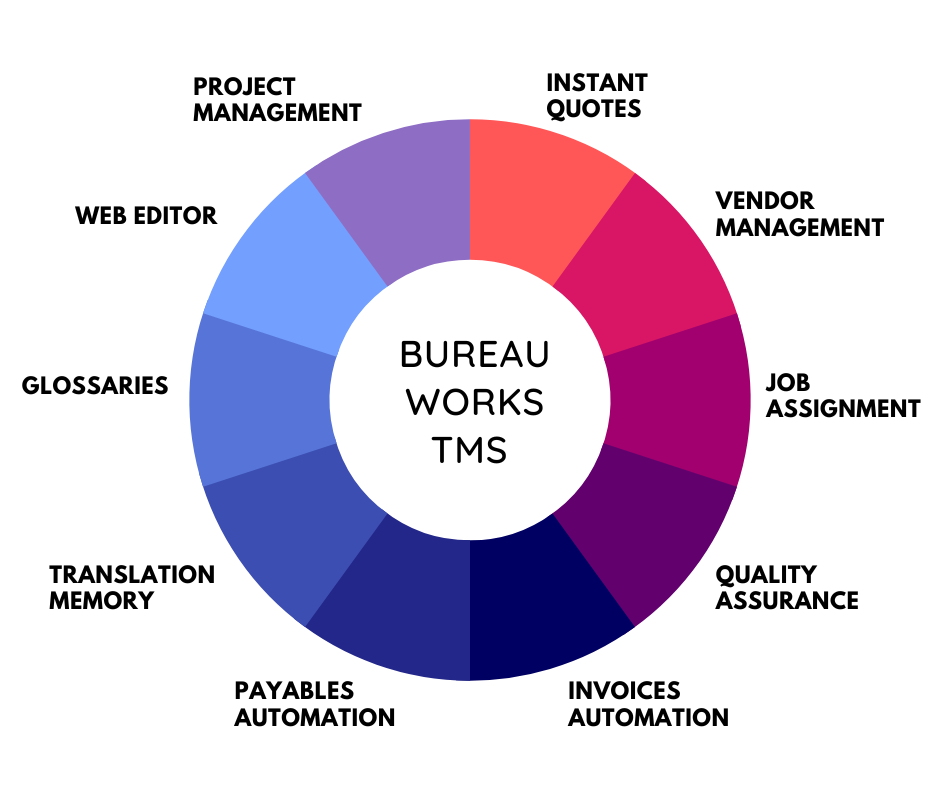

Libérez la puissance de la glocalisation avec notre système de gestion de traduction.

Libérez la puissance de la

stème de gestion de traduction.