Tradução sensível ao contexto com Modelos de Linguagem Avançados

A tradução de máquina tradicional tem sido problemática por muito tempo, mesmo com a introdução da tradução de máquina neural e conjuntos de dados de treinamento grandes. Embora possa produzir resultados interessantes quando ajustado e treinado para um domínio específico com linguagem previsível e direta, geralmente é pouco confiável e inconsistente quando aplicado a uma variedade de domínios, idiomas e circunstâncias.

Muitos tradutores respeitáveis ainda não gostam da tradução de máquina e se recusam a usá-la como um primeiro rascunho ou reescrever completamente os feeds. Isso destaca a divisão entre máquinas e humanos, mesmo com a imensa evolução da tradução de máquina nos últimos anos. Com base em nossa pesquisa, apenas uma pequena porcentagem de tradutores considera a tradução de máquina como um aliado valioso.

A tradução de máquina tradicional é ou muito genérica e errática ou muito específica, exigindo circunstâncias específicas para ser eficaz, como grandes volumes de conteúdo com estrutura linguística simples ou segregação de domínio como manuais técnicos, base de conhecimento de produtos e literatura de suporte. Mesmo motores treinados têm dificuldade em lidar com inconsistências e discrepâncias entre bases terminológicas, memórias de tradução e treinamento de corpus linguístico.

Isso inclui glossários atualizados pelos revisores ou tradutores da empresa após o processo de treinamento, diferenças entre glossários e corpus de treinamento, a necessidade de criar e manter motores específicos para obter qualidade máxima, memória de tradução desvios do corpus treinado e erros bobos como traduzir entidades ou outros nomes próprios, e falta de sensibilidade cultural ou linguística.

Esses exemplos resultam em feeds pouco confiáveis e em um processo de revisão desafiador para os tradutores. Além disso, gerenciar modelos de tradução de máquina ajustados e treinados normalmente requer um ou mais engenheiros de localização dedicados a esses esforços, algo que a maioria das agências de tradução de pequeno e médio porte e programas de localização não têm capacidade para.

Tradução sensível ao contexto com Grandes Modelos de Linguagem, no entanto, muda isso. Contexto refere-se a todas as informações que não são o próprio texto, mas ajudam o mecanismo a entender o texto e como processá-lo. Exemplos de contexto são glossários, memórias de tradução, feedback anterior e taxa de rejeição, mas o contexto pode ser qualquer informação. Com modelos de linguagem grandes que podem levar em consideração bilhões de parâmetros por design, realmente não há limite para a quantidade de contexto com a qual você decide trabalhar.

Aqui está um exemplo de levar em consideração o contexto:

Observe como há um Feed de Memória de Tradução de 89% e um Feed de Tradução de Máquina. O feed do TM chama nosso "engine" de "motor" em português, enquanto o MT chama o engine de "mecanismo" em português. O glossário, no entanto, especifica que "engine" deve ser mantido como "engine". Quando processado através do BWX Translate, nosso modelo leva em consideração essa preferência (juntamente com outras):

BWX Translate não apenas insere o termo correto de acordo com a versão mais recente do glossário, mas também faz quaisquer alterações necessárias no texto para que ele seja bem compreendido no idioma de destino, levando em consideração o contexto linguístico oferecido pela Memória de Tradução.

Com o BWX Translate, Modelos de Linguagem Avançados como o ChatGPT podem levar em conta seu próprio conjunto de dados de treinamento, memórias de tradução específicas, glossários e outros contextos relevantes para oferecer aos tradutores uma tradução sutil, contextualizada e atenta em um determinado projeto. Podemos levar em consideração as últimas atualizações de glossários e memórias de tradução em tempo real, o que significa que não é necessário enviar glossários atualizados e traduções repetidamente para servidores de tradução de máquina treinados e ajustados na esperança de que eles considerem as preferências linguísticas.

Com BWX Translate, você pode treinar e traduzir instantaneamente, e qualquer projeto de tradução, memória de tradução de qualquer tamanho, e glossário de qualquer tamanho podem se beneficiar de suas capacidades de mesclagem textual e probabilísticas linguísticas. Não há tempo de configuração e não há necessidade de treinar antecipadamente.

Com base em nossa pesquisa inicial, um motor desse tipo pode fornecer aos tradutores feeds que quebram a resistência de longa data em relação ao uso da saída da máquina. Nosso motor também abre a porta para uma conversa entre o tradutor e o motor. Faz mais sentido enriquecer um glossário se você se beneficiar dele instantaneamente, e é mais fácil confiar em uma máquina se você sabe por experiência que há pelo menos algo que se assemelha ao pensamento crítico e adaptativo.

Além da Tradução sensível ao contexto, também abrimos a porta para os tradutores interagirem com modelos de linguagem para que possam ter uma segunda opinião sobre suas escolhas, sugestões alternativas e até mesmo iniciar uma conversa quando necessário.

A tradução sensível ao contexto com Modelos de Linguagem Avançados é mais do que um processo de pré-tradução aprimorado. É um passo firme em direção aos seres humanos trabalhando com máquinas para produzir conteúdo melhor com menos esforço e em menos tempo.

Olhando para o futuro, o contexto continuará a se expandir de maneiras sem precedentes e seremos capazes de criar textos multilíngues levando em consideração o comportamento do usuário, análises da web e uma infinidade de outras informações que podem ser consumidas e compreendidas por grandes modelos de linguagem. Isso é apenas o começo e já mudou tudo.

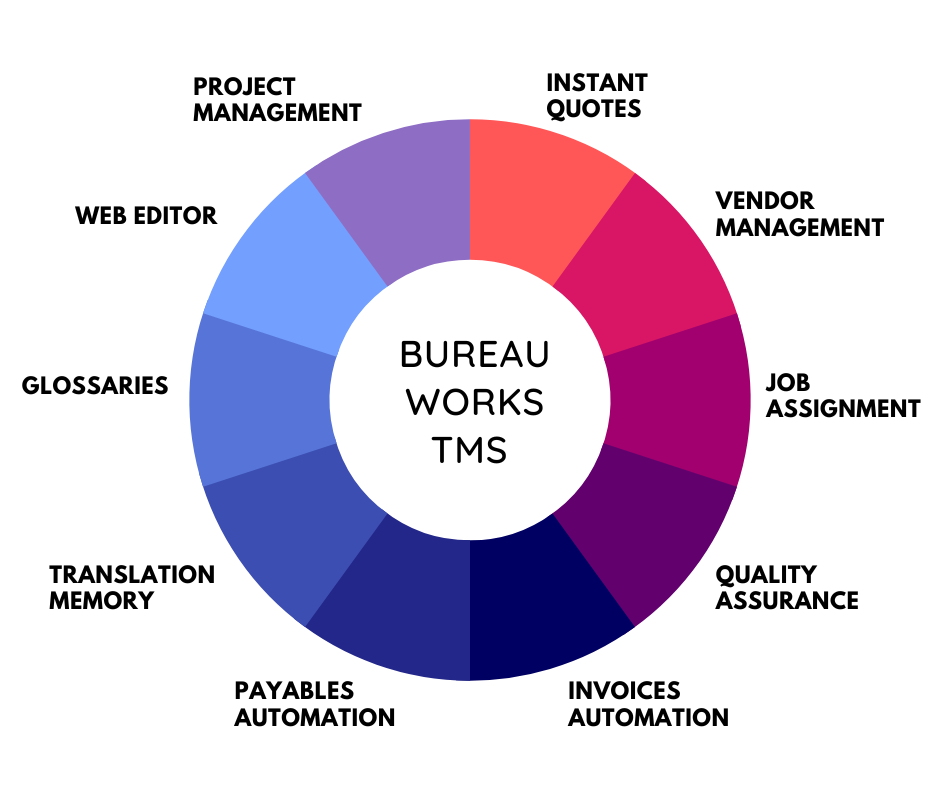

Desbloqueie o poder da glocalização com nosso Sistema de Gerenciamento de Tradução.

Desbloqueie o poder da

com nosso Sistema de Gerenciamento de Tradução.